F-Test

Neben \(R^2\) muss ein weiteres Modellmaß interpretiert werden: der \(F\)-Test des Bestimmtheitsmaßes: Der \(F\)-Test ist ein Hypothesentest und prüft in der Nullhypothese, dass das Bestimmtheitsmaß \(R^2\) \(=0\) ist, also dass das zugrunde gelegte Modell keine Varianz der abhängigen Variable erklärt. Trifft diese Nullhypothese zu, muss das Modell verworfen werden. In Veröffentlichungen findet man daher nur Modelle, die diesen \(F\)-Test „bestanden haben“, also in denen mindestens ein Regressionskoeffizient einer unabhängigen Variable von \(0\) abweicht.

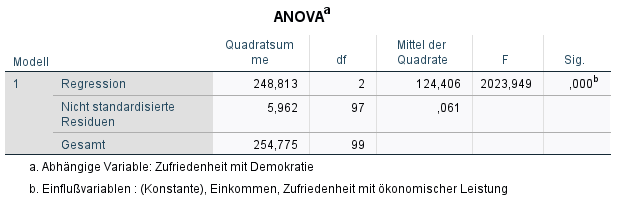

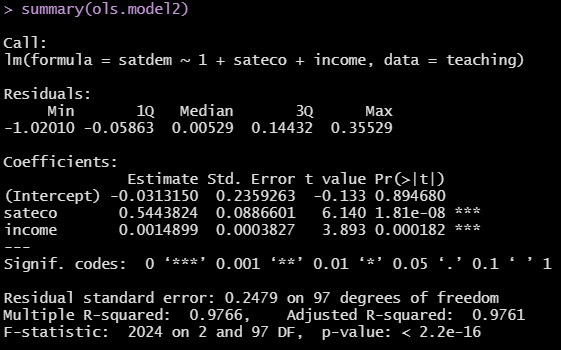

Wie interpretieren wir den \(F\)-Test nun: In der Abbildung sehen wir einen weiteren Auszug aus der Ausgabe unserer Beispielregression in SPSS.

Im Output von SPSS sehen wir In der Spalte \(F\) den \(F\)-Wert, entsprechend der Freiheitsgerade und des Konfidenzintervalls können wir entsprechend einer Tabelle der \(F\)-Verteilung ablesen, ob der \(F\)-Wert über dem Grenzwert liegt. Dieser Schritt ist hinfällig, da das Computerprogramm SPSS dies in der Spalte Sig. direkt ausgibt. SPSS gibt hier den Signifikanzwert des \(F\)-Tests direkt an. Dieser beträgt im Beispiel \(0.000\). Dieser \(p\)-Wert ist unterhalb der konventionellen \(5\%\)-Hürde (p-Wert \(0.05\)) und damit kann die Nullhypothese (dass das Modell keine Varianz der abhängigen Variable erklärt) verworfen werden und das Modell weiter interpretiert werden. Im Output der Software R müssen wir in die letzte Zeile sehen. Dort ist zuerst der gerundete F-Wert angegeben und die Parameter der Verteilung und anschließend der p-Wert, hier mit \(< 2.2e^{-16}\). Dieser Wert ist also auch kleiner als \(0.05\), denn \(2.2e^{-16} = 0.00000000000000022\).

Für eine weitergehende Auseinandersetzung, vor allem zur Berechnung der Teststatistik, ist folgende Literatur zu empfehlen: Urban & Mayerl (2011, Kapitel 3.4.2, Kapitel 3.3.3 & Kapitel 3.4.3).